«МН»: Кто и как сдерживает развитие искусственного интеллекта?

Ускова: Есть три уровня сдерживания: технологический, политический и социальный. Последний заключается в неспособности населения принять искусственный интеллект. Технологический — в том, что развитие ИИ идет скачкообразно, так что общество и власти оказываются, как правило, не готовы к очередному переходу на качественно новый уровень. Так было в 2011–2012 годах, когда перешли к нейронному программированию и ИИ перестал быть демонстрацией или игрой, — образовался рынок.

Следующий скачок ожидается в течение 2 лет. IBM уже анонсировала создание чипов, выполненных по 2-нанометровому техпроцессу, которые на 45% эффективнее сегодняшних аналогов при том же уровне энергопотребления.

Новые нейрочипы, то есть устройства, в которые вшивается структура нейронной сети, позволят сильно ускорить процесс. После этого ближайшие 10 лет человечество потратит на повышение уровня искусственного интеллекта.

«МН»: А что с политикой?

Ускова: Это самая сложная из всех преград. Именно благодаря позиции властей разных стран искусственный интеллект из глобальной истории становится местечковой. Нельзя заниматься внедрением широкомасштабных систем ИИ на планете при таком похолодании в межгосударственных отношениях. Даже на уровне беспилотных автомобилей нужны конструктивный диалог между странами, возможность обмена правилами дорожного движения, страховыми регламентами, стандартами в разработке систем.

Но как это делать, когда температура в дипломатии опустилась до уровня холодной войны, а кое-где вспыхивают и откровенно горячие конфликты, как сейчас на Ближнем Востоке? А ведь искусственный интеллект — это технология без границ, требующая большого объема межстранового взаимодействия.

«МН»: Есть ли страны, тормозящие развитие ИИ?

Ускова: Если только неосознанно. Все торможение связано с разгильдяйством. Неповоротливость бюрократической машины, ее коррумпированность, отсутствие элементарной грамотности у чиновников и отсутствие государственной политики и стратегии в этой сфере — верный путь к тому, чтобы проиграть уже вовсю идущую гонку.

По моему мнению, Лев Толстой был не прав, преуменьшая роль личности в истории и так высоко ценя значимость народных масс. Во всяком случае, в наш век, в эпоху цифровых технологий личности могут всерьез ускорить процесс развития или, напротив, его затормозить. Именно они готовят стратегии или продвигают бизнес, а народ, как водится, безмолвствует.

Сфера искусственного интеллекта — не просто передовая, она в определенной степени сегодня формирует историю, создает будущее человечества.

А это значит, что если в ней делать исключительно тактические шаги, реагируя на происходящее, и не задумываться о стратегии и будущем, то проигрыш обеспечен. В какой-то степени искусственный интеллект становится индикатором лидерства в мире.

В большой политике все давно уже определяет не ядерное оружие, потому что никто всерьез не думает им пользоваться, а эмиссионный центр. На верхней ступеньке мирового пьедестала — страна, печатающая деньги, которыми пользуется весь мир. На данный момент это США. Но мир меняется, его ждет новая революция — масштабный переход на цифровые финансовые системы под управлением ИИ. Субъективный фактор исчезнет, заработают чистые математические модели.

Собственно, эта бескровная революция уже идет — уход в цифру всех биржевых операций тому свидетельство. Будущее мировое лидерство за тем государством, у которого окажется самый продвинутый искусственный интеллект, управляющий финансовыми системами. Чем не стратегическая задача?

«МН»: То есть ИИ все же будет иметь национальность?

Ускова: Он и сейчас ее имеет. ИИ работает в информационном пространстве: если оно интернациональное, то и он будет интернациональным, а если информпространство ограничено границами страны, то и ИИ будет американский, китайский или русский. Это видно в соцсетях.

«МН»: Согласно российской стратегии развития искусственного интеллекта, к 2024 году «должен существенно повыситься уровень участия российских специалистов в международном обмене знаниями, их вклад в создание открытых библиотек ИИ». Осталась пара лет. Задача выполнена?

Ускова: Повышать уровень такого участия можно, но не нужно. В сфере ИИ сегодня самая жесткая межстрановая конкуренция. Все страны секретят разработки в этой сфере. Здесь вращаются гигантские деньги, как и в области микроэлектроники, где и вовсе льется кровь, а США не на шутку схлестнулись с Китаем.

Штаты вообще создали структуру, следящую за разработками в области ИИ, и она работает так точно и жестко, что почище любого КГБ будет. США контролируют все инвестиции в сферу ИИ, чужие деньги допускаются редко.

Словом, в сфере разработок ИИ вовсю идет охота за головами. Если Россия намерена в очередной раз профукать свои «мозги», как она это сделала в 1990-х, я помешать не могу. Я вообще не понимаю, зачем властям понадобился такой пункт в стратегии. Для красного словца?

«МН»: Эксперты из ВШЭ и РАНХиГС утверждают, что для ИИ нужно продумать два аспекта этики: принципы, лежащие в основе принимаемых ИИ решений, и поведение ИИ в ситуации, которые напрямую касаются людей. Что-то из этого уже разработано?

Ускова: Такая постановка задачи — абсурд. Искусственный интеллект — это система, аппаратно-программный комплекс, который разрабатывается по определенному техническому заданию. Он обладает определенной свободой принятия решений в той функциональной зоне, для которой разрабатывается.

Если у вас техническое задание создать ИИ, имитирующий по всем параметрам человека, то де-факто вы создаете конкуренцию себе и всему человечеству — с неочевидными последствиями.

Если же вы озабочены решением конкретной функциональной задачи и ваш ИИ должен сеять и пахать или развозить людей, то его функционал на уровне технической задачи изначально ограничен. Внутри могут возникать этические коллизии, но это ограничение для создателей ИИ, а не для самого интеллекта. Иными словами, это система координат, из которой разработчики не имеют права выходить.

Но это не новость: Айзек Азимов еще в 1942 году описал три закона робототехники. Как и всякий писатель-фантаст, создающий миры, он предвидел, что, по мере того, как машины будут получать все большую автономию в своих действиях, человеку потребуется ввести какие-то ограничения, а иначе цивилизация исчезнет.

Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред. Робот должен повиноваться всем приказам, которые дает человек, кроме тех случаев, когда эти приказы противоречат Первому Закону. Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому или Второму Законам.

Айзек Азимов

«Хоровод»

Грустно от того, что человечество, выйдя на нужный технический уровень, до сих пор не приняло хартии, содержащей три закона робототехники, — притом что и слепому очевидно, что ИИ может составить конкуренцию хомо сапиенс.

Впрочем, думаю, что отсутствие хартии — это психологическая история. Тяжело придумывать этику для роботов, когда развалилась этика для людей.

«МН»: А как научить ИИ моральным принципам — тому, что такое хорошо и что такое плохо?

Ускова: Это нетрудно. Проблема не в ИИ, а в людях: они определяют, что хорошо, что плохо. Но сколько людей, столько и мнений: кто-то считает допустимым сморкаться в скатерть, для кто-то употребление литературного бранного слова — нонсенс. А кому-то море по колено, он — бог, поэтому вправе взять пистолет и стрелять.

За последние 30–40 лет в экономически развитых странах серьезно ослабла религиозная этика. В сериале про калифорнийскую молодежь «Силиконовая долина» есть эпизод о том, как акционеры стартапа исключали из своих рядов человека, который признался в соцсетях, что он христианин и посещает по воскресеньям церковь. Для мира американских компьютерщиков это оказалось неприемлемо, было расценено как «вата» и мракобесие.

Прогрессивное человечество смыло в унитаз большинство религиозных догматов вместе с сопутствующей этикой. Сегодня люди в очередной раз сочли себя богами. Но быть богом трудно, как известно, — а без этических норм и вовсе невозможно. За окном Смутные времена — пусть на ином технологическом уровне и историческом витке. Надежда лишь на «новейший» завет, потому что людям нужна единая система ценностей и правил.

«МН»: Но ИИ уже сегодня должен делать нелегкий моральный выбор. Например, если речь идет об автопилотах и судебных системах.

Ускова: Это пугает, но еще раз: проблема не в ИИ, а в том, что люди сами не могут определиться, каковы критерии для судебного вердикта в том или ином случае. Если разработчики не в состоянии четко сформулировать свою позицию, то как они составят техзадание для ИИ?

Вот один европейский автопроизводитель принял решение, что ИИ в его машинах всегда в случае ДТП будет спасать пассажиров в салоне. С точки зрения морали это решение спорно и негуманно, потому что на дороге могут быть, например, дети, но по части маркетинга все верно — иначе такой автомобиль не продать.

«МН»: И как быть?

Ускова: Ограничивать свободу разработчиков искусственного интеллекта для автопилотов со стороны государства. Сегодня везде, где ИИ соприкасается с человеком, он находится во власти разработчиков, которые ничем и никем не ограничены. А должны! Думаю, что человечеству потребуется еще максимум 10 лет, чтобы осознать эту простую истину.

«МН»: Вам приходилось обращаться к властям за разрешением на обход или использование тех или иных этических норм для ИИ?

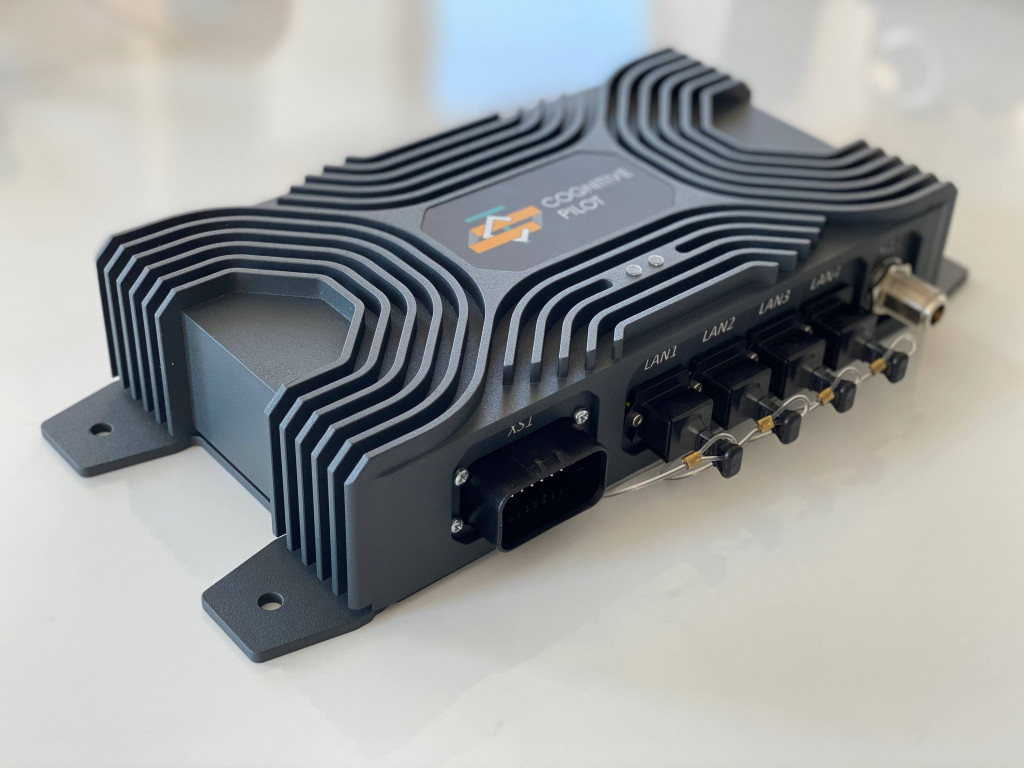

Ускова: Мы ушли от этого, выбрав те сферы применения ИИ, где сложных этических проблем не возникает. До сих пор не пойму, зачем понадобилось поднимать столько шума из-за того, что Cognitive Pilot не видит автомобильный сектор как рынок на ближайшие 5 лет? Мы не ссорились с Маском (ходили такие слухи), нас никто не подкупал (и о таком шептались), но рынок ИИ для автотранспорта так и не сложился. Потому что не может быть рынка без правил игры.

Действовать, как Tesla, — методом проб и ошибок, взрывая ракеты и давя пешеходов, — мы не хотим и не можем. Маск — национальный герой, и власти США воспринимают жертвы как неизбежные этапы в достижении цели.

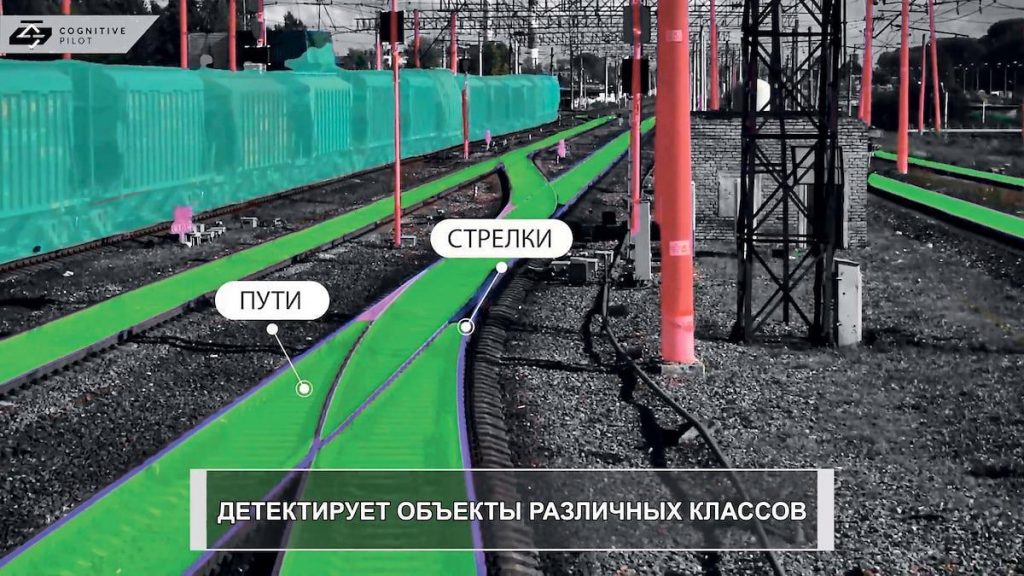

Нам же придется ждать, когда будут сформулированы четкие правила игры для ИИ на автодорогах, когда разработчики смогут задать ясный алгоритм действий. По моим подсчетам, такое станет возможным не раньше чем через 5–6 лет. А пока Cognitive Pilot ушел в регламентированную сферу железнодорожных перевозок и агросферу, где не возникает спорных дорожных ситуаций.

В агросекторе мы всегда спасаем все живое, что находится на пути комбайна. Дело тут не только в любви к фауне, но и в том, что силос, если в него попали останки чего-то живого, становится ядовитым для коров.

«МН»: Должен ли искусственный интеллект нести ответственность?

Ускова: Это разработчик должен нести ответственность. Собака же не несет ответственность, когда кого-то кусает. Отвечает хозяин. Ответственность несут граждане, члены сообщества, выработавшие правила. ИИ — не гражданин, у него нет паспорта.

«МН»: ЕС предлагает превентивное регламентирование ИИ-разработок, исходя из принципа предосторожности. Это справедливо?

Ускова: Что до превентивных регламентаций, то если это на уровне постановки задач, то такая позиция вполне оправдана, особенно если речь идет о запрете на убийство человека. Но если это будет влезание бюрократии в коды — мол, объясните нам, чиновникам, как устроена нейронная сеть, — то ИИ в Европе просто не будет.

Этические проблемы из-за внедрения ИИ в повседневную жизнь будут многообразны — от контроля за гражданами до автокатастроф.

Этика ИИ отличается тем, что ИИ в ряде случае должен будет сделать моральный выбор, а таковой сложно формализовать и заложить в алгоритм.

Нужны в первую очередь жесткие этические нормы для разработчиков ИИ.

Введение личной ответственности роботов при условии наделения их правосубъектностью возможно.

Этика и «цифра»: этические проблемы цифровых технологий

Доклад экспертов РАНХиГС, ВШЭ и Центра подготовки руководителей цифровой трансформации

«МН»: В Брюсселе пояснили, что ограничения могут коснуться работ искусственного интеллекта в системах по сбору данных. Нужно будет получать разрешение на использование биометрии, вводится спецнадзор за беспилотниками.

Ускова: Беспилотники и так «трэкают» свое передвижение. Они тем и хороши, что полностью фиксируют происходящее, какой тут еще спецнадзор? Беспилотники — это максимальная прозрачность. А вот ограничивать данные — вообще глупость. Как только ЕС на это пойдет, у них понизится качество систем: ИИ учится на данных — чем больше данных, тем умнее ИИ. А с глупыми ИИ Европа быстро проиграет соревнование.

«МН»: В Европе выделили четыре этических принципа для ИИ-систем: уважение к человеческой личности, предотвращение ущерба, беспристрастность и предсказуемость.

Ускова: Ну какая может быть пристрастность у машины?! Да и что такое уважение к человеческой личности?

Это когда подходишь к машине, оборудованной ИИ: «Ты меня уважаешь?» Если ответ отрицательный, внутрь не лезешь. Только если скажет: «Я тебя обожаю, дорогой, садись, поехали». Звучит как анекдот.

Я вас уверяю: машина беспристрастна всегда, никаких предпочтений у нее нет, она предсказуема на все 100%, потому что работает по заложенному в нее алгоритму.

«МН»: И все-таки: есть ли что-то, что должно попасть под запрет в сфере ИИ?

Ускова: Все, что связано с военной сферой. Как только человеку становится не больно, остатки моральных принципов у него исчезают. Как только война превращается в компьютерную игру, то убитые — это лишь картинки на экранах мониторов.

Если такое случится, то это уже будет не остановить. Мое мнение как разработчика — супер-ИИ, который будет не просто помощником человека, как сейчас, а станет руководить жизнедеятельностью городов и стран, — это вредно и опасно. Впрочем, если по военной истории опасность очевидна каждому, то по части создания супер-ИИ — увы, нет.