Все началось с того, что в декабре журналисты Bloomberg обнаружили дипфейки с умершими — в TikTok завирусились видеоролики, созданные с помощью генеративного искусственного интеллекта, с людьми, погибшими в трагических обстоятельствах, подобных теракту 7 октября в Израиле.

После расследования Bloomberg видео быстро подчистили. А уже в этом году в TikTok стал вирусным еще один ролик, где девочка по имени Алисса Бет Гернси подробно рассказала, как ее опекун «вымещал свое разочарование, бил и безжалостно разбивал голову об автокресло». Девочка скончалась от полученных травм в 2009 году, но этот ролик, продукт генеративного искусственного интеллекта, «оживил» ее.

Позже TikTok стал заполняться видеороликами с мертвыми детьми и подростками, подробно описывающими их собственную смерть. Короткие видео мгновенно становились вирусными, и платформа была не в силах остановить этот поток.

Да, эти видео противоречили политике TikTok, которая запрещает изображения частных лиц и несовершеннолетних, созданные искусственным интеллектом, а также «ужасный» или «вызывающий беспокойство» контент. Однако на платформе продолжают существовать десятки и сотни этих видео, а также аккаунты с десятками тысяч подписчиков, публикующие что-то подобное. На некоторых постах авторы даже ставят метки о том, что контент был сгенерирован ИИ, что в целом дает команде модераторов четкий сигнал о том, что это может быть дипфейк, однако эти видео все еще доступны — их могут увидеть все. Даже дети.

Дипфейки — это первое испытание, которое генеративный ИИ бросил нам, потому что они фундаментально устраняют всякое доверие.

Виджей Баласубраманьянгендиректор компании по обнаружению телефонного мошенничества Pindrop

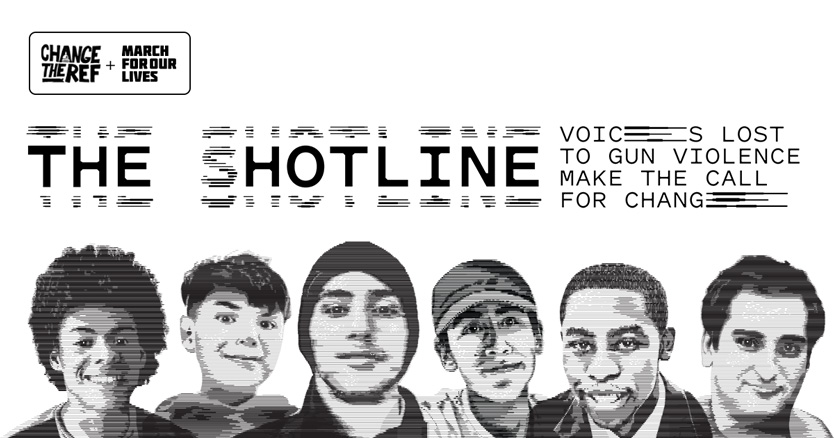

История Алиссы Бет Гернси и остальных детей по-прежнему вызывает множество вопросов: кто и с какой целью «оживил» их и что думают об этом родители? Однако эта тема на днях получила неожиданное развитие: родители подростка, убитого террористом, уже по собственной инициативе создали проект The Shotline, использующий ресурсы ИИ-стартапа ElevenLabs для воссоздания голосов детей, погибших от огнестрельного оружия. Проект был запущен через 6 лет после теракта во Флориде в 2018 году, когда неизвестный застрелил 17 человек, включая шестерых детей младше 10 лет.

Супружеская пара воссоздала голоса этих шестерых детей с помощью ИИ и образцов их голосовых сообщений из соцсетей, после чего открыла к ним доступ всем неравнодушным. На лендинге человек может ввести свой почтовый индекс, и ему предложат позвонить главе местной администрации голосом одного из погибших. Голос объясняет, откуда он взялся, и призывает ужесточить закон, связанный с ношением оружия. «Другие жертвы, такие как я, тоже будут звонить», — так завершается монолог «умершего» ребенка. При желании родители могут загрузить образцы голоса своего погибшего ребенка, чтобы использовать его для звонка чиновнику.

Отзывы в сети показывают, что люди воспринимают эту программу неоднозначно. Некоторые считают, что использование голосов детей в таком контексте является глумлением над их смертью.

Искусственный интеллект — как джинн, выпущенный из бутылки, а такие истории имеют как хороший, так и плохой конец. Дипфейки с умершими детьми дают нам возможность испытать весь спектр эмоций, создавая опыт, который в равной степени является поучительным (привет американским нерасторопным чиновникам), душераздирающим и приводящим в бешенство — очень похожий на настоящее горе.

Пока я искренне верю, что все мы пожалеем об использовании технологий таким образом. А обществу предстоит определить рамки того, есть ли загробная жизнь в цифровом мире. Об этом — в следующих сериях.