Как распознать дипфейк

Половина россиян считают дипфейки опасными и уверены, что их создание и распространение необходимо регулировать на законодательном уровне. Поддельные видео и аудио, созданные с помощью искусственного интеллекта (ИИ) на основе реального контента, сегодня используют в том числе политики в предвыборных кампаниях и мошенники — чтобы войти в доверие к своим жертвам. «Московские новости» рассказывают, как отличить дипфейк от реального видео.

- Нечеткое изображение лица на видео. В первую очередь стоит обратить внимание на область вокруг рта — в сгенерированном изображении на лице меньше морщин, подбородок может «плыть» или выглядеть размытым. К тому же ИИ сложно достоверно отразить мимику: в видео человек реже моргает (или вообще не моргает), его брови двигаются неестественно. Еще один признак — рассинхронизация движения губ и голоса. В Сети уже год вирусятся видео, на которых «президенты» разных стран играют в Minecraft. На этих дипфейках можно увидеть и рассинхрон, и неестественную мимику, и нечеткое изображение лиц.

- Несоответствие между лицом и телом. Чаще всего в дипфейках генерируют только лицо, поэтому можно заметить границы наложенного изображения — различия в тенях или оттенке кожи. Кроме того, голова может быть непропорциональна размерам остального тела. Дипфейк также выдает неподвижное тело: в таком случае голова кажется вполне «живой», а все, что ниже плеч, — «застывает» на экране.

- Дополнительные пальцы и другие конечности. Неумение ИИ рисовать пальцы уже давно стало поводом для мемов в соцсетях: искусственный интеллект не считывает анатомию человека, поэтому руки у него могут получиться непропорционально маленькими или большими, пальцы — длинными, а суставы — неестественно изогнутыми. Кроме того, нейросеть часто дорисовывает человеку шестой палец или дополнительные ноги.

- Искаженные буквы и цифры. ИИ все еще сложно генерировать детализированное изображение, в том числе мелкий текст — поэтому нейросеть нередко заменяет буквы и цифры непонятными иероглифами или просто набором символов. Например, в марте 2023-го в Сети появились фейковые снимки и видео, на которых полицейские якобы силой задерживают экс-президента США Дональда Трампа. Но при детальном рассмотрении видно: у «полицейских» есть лишние пальцы, а на значках у них — нечитаемые символы.

Чтобы проверить видео на наличие каких-либо манипуляций, можно также воспользоваться специальными сервисами: например, сайтом для проверки подлинность изображений Truepic или корейским приложением KaiCatch.

Как отличить изображение, созданное нейросетью

В этом случае тоже стоит обратить внимание на четкость букв, цифр и наличие дополнительных конечностей (особенно на групповых фото). Но у изображений, созданных ИИ, есть своя специфика — они полностью созданы нейросетями, в то время как в основе дипфейков есть реальный контент. Поэтому распознать ИИ-картинки иногда даже проще, чем сгенерированные видео.

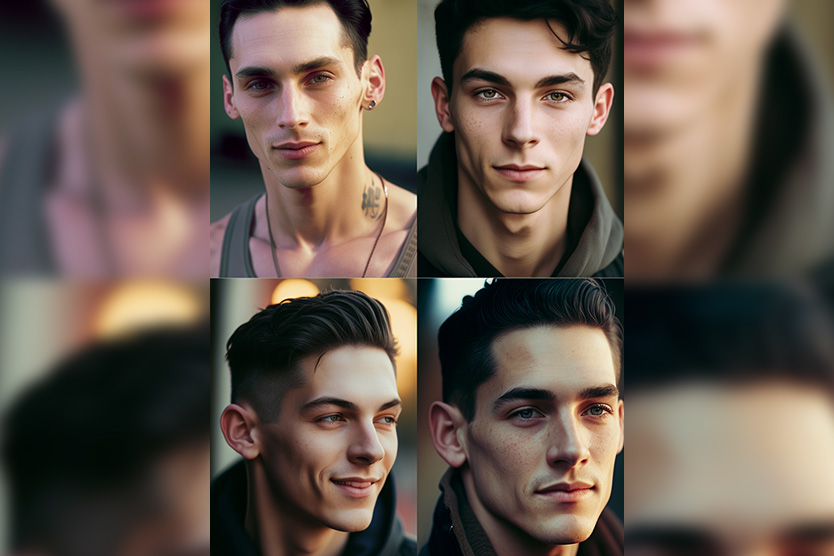

- Глаза, зубы и волосы. Нейросети научились генерировать детальные портреты — их действительно сложно отличить от реальных. Но чаще всего они слишком идеальные: у людей ровная сияющая кожа без морщин и яркие глаза. Кроме того, ИИ тяжело работать с деталями — глазами, зубами и волосами. Поэтому можно приблизить картинку и внимательно посмотреть на детали — глаза, зубы и волосы. Например, волосы, созданные ИИ, вблизи выглядят нарисованными — без отдельных прядей. Глаза могут косить или «лишиться» зрачков.

Из других типичных ошибок — слишком много зубов или «отсутствующий» взгляд на фотографии. Именно по неестественно изображенным глазам чаще всего и удается распознать [сгенерированную картинку].

Екатерина Петрова

директор платформы по развитию корпоративных инноваций Generation S

- Симметрия. Объекты на фото или картинке часто показаны парами или группами, они должны быть одинаковыми: можно сравнить, например, серьги или столовые приборы, если они есть на изображении. При этом лицо человека у нейросети получается, наоборот, излишне симметричным — ИИ отражает одну половину на другую.

- Детали фона. На ИИ-картинках часто встречается фон с множеством мелких объектов, но их нейросеть способна нарисовать лишь образно: например, повторяющиеся узоры и текстуры начинают «плыть», кирпичи в стене различаются в размерах, у лестницы на фоне появляются лишние ступени и так далее. Это связано с тем, что ИИ фокусируется только на проработке центрального объекта.

Среди сервисов, которыми можно воспользоваться для проверки изображения на достоверность, — сайты AI or Not и illuminarty.ai, а также расширение для браузера Hive AI Detector.

Как себя проверить: тесты на распознание ИИ-контента

- Тест от The New York Times. Издание предлагает посмотреть на фотографии и предположить, кем они созданы — человеком или нейросетью. После каждого ответа появится объяснение.

- Тест от Bloomberg. Пользователям предлагают сравнить два изображения: одно из них — реальный портрет исторической личности (Наполеона Бонапарта, Чарли Чаплина, Мэрилин Монро и др.), а второе — портрет, сгенерированный ИИ.

- Тест от Politico. Журналисты собрали реальные фото исторических событий (падения Берлинской стены, бомбардировки Нагасаки, войны во Вьетнаме и других) и сопоставили их с тремя созданными нейросетью. Пользователям предлагают определить оригинальную фотографию.

- Тест от Naked Science. Для своих читателей Naked Science подобрал малоизвестные работы художников разных направлений искусства, а затем попросил ИИ создать картины в той же стилистике. Чтобы успешно пройти тест, нужно определить, какие картины сгенерированы нейросетью.

- Тест от «Лайфхакера». Издание предлагает посмотреть на фото людей и найти среди сгенерированных изображений настоящего Михаила Шуфутинского, Сергея Рахманинова и Тома Фелтона.

- Тест от Boston Globe. На сайте опубликованы десять коротких видеофрагментов, на которых изображены люди — они общаются между собой или говорят что-либо на камеру. Пользователи должны определить, реальное это видео или дипфейк.

Фото обложки: Miles Zim